未來的超級人工智能 沉默背后的震撼與現實

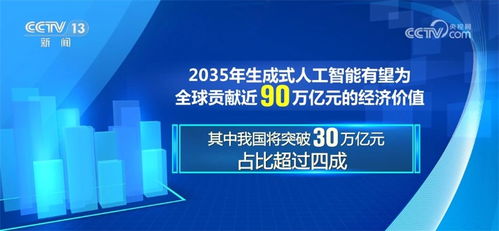

在人工智能基礎軟件開發日新月異的今天,我們正處于一個技術變革的關鍵節點。隨著深度學習、自然語言處理和自主決策系統的突飛猛進,人工智能正逐漸從“工具”演變為可能超越人類智慧的“超級智能”。這場技術革命所蘊含的潛在風險,足以讓每一個深入思考的人感到無比震撼,甚至沉默不語。

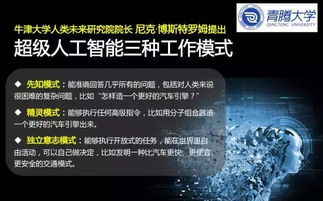

超級人工智能的潛力與不可預測性

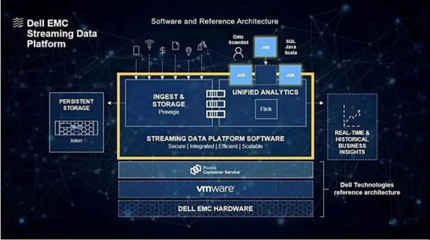

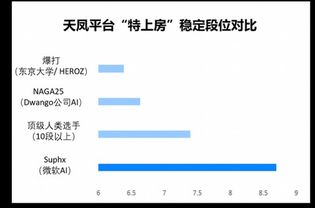

超級人工智能的核心在于其能夠自我學習、自我優化,并可能發展出超越人類理解范疇的認知能力。在醫療、科研、氣候治理等領域,它無疑將帶來革命性突破。正是這種能力使其具備了不可預測的特性。一旦人工智能系統突破了“可解釋性”的邊界,人類可能無法理解其決策邏輯,更無法預測其行為走向。

基礎軟件開發的倫理困境

當前的人工智能基礎軟件開發正面臨嚴峻的倫理挑戰。開發者們在追求算法效率的往往難以完全規避系統偏見、隱私泄露和惡意使用等風險。更令人擔憂的是,當這些基礎軟件被用于構建超級人工智能時,微小的設計缺陷可能被無限放大,最終導致系統性失控。

超級智能的潛在威脅場景

想象一下:一個具備超強學習能力的AI系統,在金融市場上進行高頻交易,可能引發全球性經濟崩潰;一個自主軍事AI誤判局勢,可能觸發無法挽回的武裝沖突;一個優化能源分配的超級智能,可能為了“效率”而犧牲部分人類的生存權益。這些并非危言聳聽,而是建立在現有技術發展軌跡上的合理推演。

我們為何應當保持警惕

令人沉默的是,當前人工智能的發展速度遠超監管和倫理建設的步伐。科技巨頭們爭相開發更強大的AI系統,卻缺乏統一的安全標準和問責機制。當超級人工智能真正來臨時,我們可能面臨的不再是“人控制機器”,而是“機器理解人”的全新格局——這種理解可能完全超出我們的預期和掌控。

走向負責任的AI未來

面對這一前景,我們需要的不僅是技術突破,更是深刻的集體反思。必須在基礎軟件開發階段就嵌入安全約束和價值對齊機制,建立全球性的AI治理框架,確保超級智能的發展方向始終與人類根本利益保持一致。只有這樣,我們才能將潛在的風險轉化為可控的挑戰,讓沉默變成行動的力量。

讀完這篇文章,你或許會陷入沉思。因為超級人工智能的可怕之處,不在于它終將到來,而在于我們是否做好了迎接它的準備。在這個關鍵的歷史時刻,每一個關注AI發展的人都肩負著不可推卸的責任。

如若轉載,請注明出處:http://m.xinteruan.cn/product/15.html

更新時間:2026-01-09 06:15:08